|

|

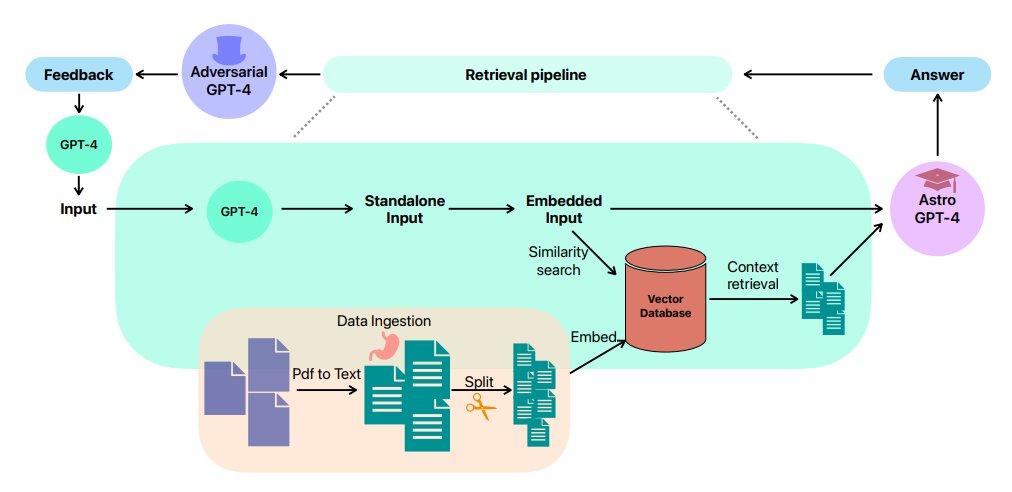

使用OpenAI的GPT-4模型的对抗性上下文提示工作流。程序从银河天文学论文的预处理和嵌入开始。对嵌入的查询进行相似性搜索,并检索相关的文档块。执行进一步的上下文压缩以从组块中移除不相关的信息。这些压缩文本作为GPT-4实例的输入,产生一个想法。这个想法然后被第二个GPT-4模型评论,反馈被第三个GPT-4模型调节。学分:arXiv (2023)。DOI: 10.48550/arxiv.2306.11648

()据今日宇宙(安迪·托马威克):几乎在互联网上的任何地方,你都几乎不可能避开关于人工智能的文章。即使在德州大学,我们也出版了几本。通常,他们关注的是特定研究小组如何利用技术来理解大量数据。但这种模式识别并不是人工智能擅长的全部。事实上,它变得很有抽象思维的能力。抽象思维有助于发展新的科学理论。带着这种想法,来自欧空局、哥伦比亚大学和澳大利亚国立大学(ANU)的一组研究人员利用人工智能提出了天文学中的科学假设。

具体来说,他们是在星系天文学的子领域这样做的,这个子领域专门研究星系的形成和物理学。最近发表的一篇关于arXiv预印服务器的论文提到,他们选择这个子领域是因为它的“综合性”,这需要“来自不同子领域的知识”

这听起来正是人工智能已经擅长的。而是一个标准的大型语言模型(LLM ),就像最近变得最熟悉的那些(ChatGPT、Bard等)。)没有足够的学科知识来在那个领域发展合理的假设。它甚至可能成为“幻觉”的牺牲品,一些研究人员(和记者)警告说,这是与模型互动的负面影响之一。

为了避免这个问题,由ANU的Ioana Ciuc和Yuan-Sen Ting领导的研究人员使用了一段被称为应用程序编程接口(API)的代码,它是用Python编写的,称为Langchain。这个API允许更高级的用户操作像GPT-4这样的LLM,它是ChatGPT的最新基础。在研究人员的案例中,他们从美国宇航局的天体物理数据系统下载了1000多篇与银河天文学有关的科学文章,然后将其加载到GPT 4号上。

研究人员的实验之一是测试该模型可以访问的论文数量如何影响其得出的假设。他们注意到,该研究所提出的假设中,只有10篇论文与全部1000篇论文之间存在显著差异。

但是他们自己是如何判断假说的有效性的呢?他们做了任何自尊的科学家都会做的事情,招募了该领域的专家。准确地说,是两个。他们要求他们只是假设基于思想的独创性,测试假设的可行性,以及其基础的科学准确性。专家们发现,即使只有10篇论文的有限数据集,阿斯特罗-GPT提出的假设(他们称之为他们的模型)的评分也仅略低于一名合格的博士生。通过查阅全部1000篇论文,阿斯特罗·GPT的得分达到了“近乎专家的水平”

决定提交给专家的最终假设的一个关键因素是使用“对抗性提示”对假设进行提炼。虽然这听起来有些咄咄逼人,但它只是意味着,除了开发假设的程序之外,另一个程序也在相同的数据集上接受了训练,然后向第一个程序提供了关于其假设的反馈,从而迫使原始程序改善其逻辑谬误,并通常创造出更好的想法。

即使有对抗性的反馈,天文学博士生也没有理由放弃在自己的领域提出自己独特的想法。但是,这项研究确实指出了这些LLM未被充分利用的能力。随着它们被越来越广泛地采用,科学家和外行人可以越来越多地利用它们来提出新的更好的想法进行测试。 |

|